What is GS?

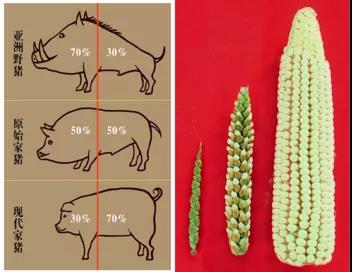

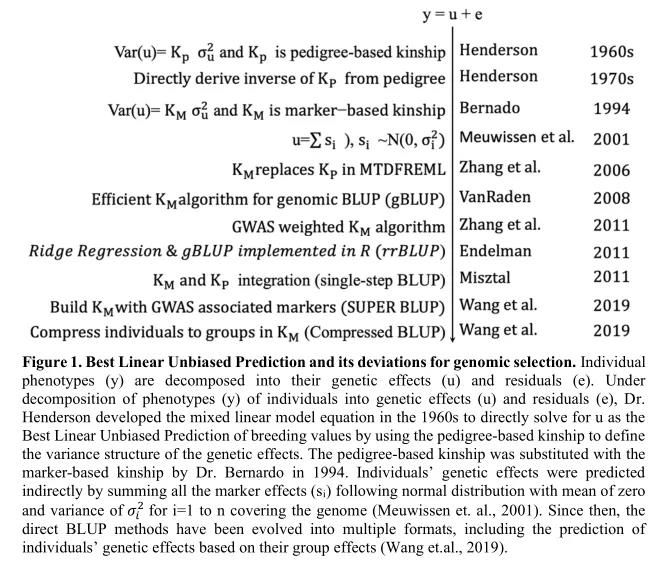

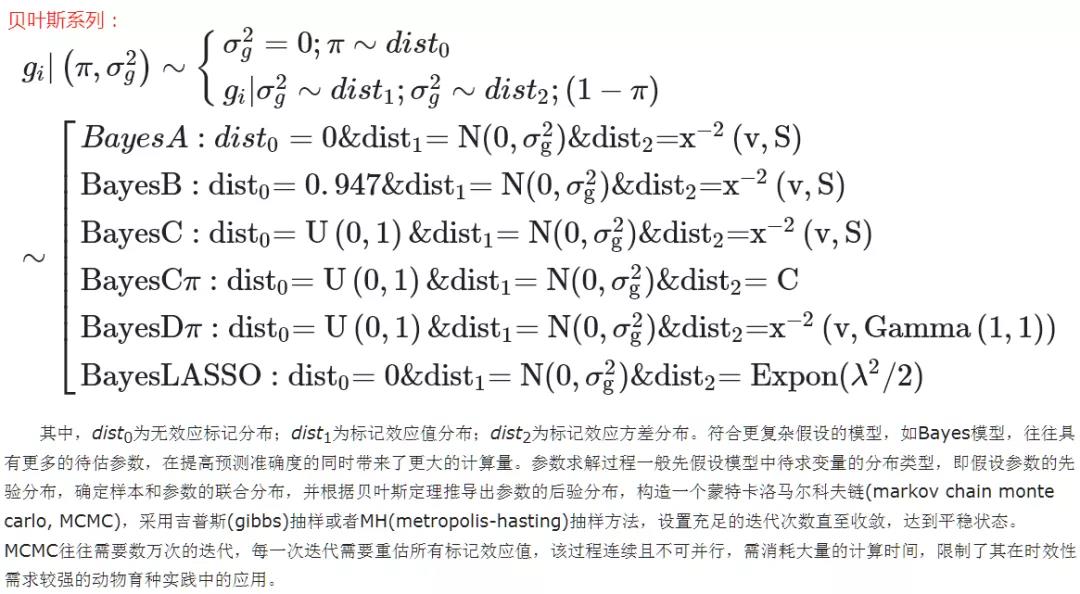

全基因组选择(Genomic Selection,简称GS)这一概念由挪威生命科学大学的Theo Meuwissen 教授于2001年提出。它是一种利用覆盖全基因组的高密度分子标记进行选择育种的方法,可通过构建预测模型,根据基因组估计育种值(Genomic Estimated Breeding Value, GEBV)进行早期个体的预测和选择,从而缩短世代间隔,加快育种进程,节约大量成本。 野猪到家猪身体比例变化图与玉米野生种到栽培种的变化图 GS预测模型 统计模型是全基因组选择的核心,极大地影响了预测的准确度和效率。根据统计模型的不同,主要有以下几类: 1、BLUP ALPHABET(BLUB系列) 又称为直接法,此方法把个体作为随机效应,训练群体(参考群体)和预测群体(候选群体)遗传信息构建的亲缘关系矩阵作为方差协方差矩阵,通过迭代法估计方差组分,进而求解混合模型获取待预测个体的估计育种值; 根据不同信息构建的亲缘关系矩阵可建立不同的模型,比如以传统系谱矩阵构建的ABLUP模型,以基因型矩阵构建的GBLUP模型,以系谱和基因型结合矩阵构建的ssBLUP模型(single-step BLUP)等(如下图,BLUP发展历程)。 2、BAYESIAN ALPHABET(贝叶斯系列) 又称为间接法,此方法则首先在训练群体(参考群体)中估计标记效应,然后结合预测群体(候选群体)的基因型信息将标记效应进行累加,最后获得预测群体(候选群体)的个体估计育种值; 根据预先假定基因的数量和基因效应值分布的不同,可以建立不同的贝叶斯模型,如BayesA、BayesB、BayesC、BayesCπ、Bayes LASSO等,其差别主要在于:是否所有标记都有效应值,标记效应是否符合相同分布以及标记效应方差服从何种分布。 简言之,直接法是通过构建A/G/D/H等矩阵求解育种值,间接法是通过计算标记效应来获得育种值。性状遗传构建复杂多样,目前还没有一种模型能广泛适用于所有性状。间接法的假设更加复杂,但是更加符合性状的遗传构建,对于性状的遗传解析具有很好的理论研究价值,缺陷是计算速度较慢,需要多次迭代才能达到收敛。 3、MACHINE LEARNING(ML,机器学习) 机器学习(ML)是计算机科学的一个领域,它使用算法来获得从经验中自动学习和改进的能力,而无需明确编程。在大基因组数据分析中,与传统统计方法相比,ML方法的一些主要优势包括: 1. 它们能够处理“large p, small n”问题; 2. 它们是black-box方法,不需要任何关于影响性状的可靠变量分布或优先遗传模型的先验知识; 3. 它们可以考虑特征之间的多重交互或相关性; 由于单个算法的过程中内置了训练和验证程序,允许用户预定义训练和验证数据集,或者允许ML对大量群体应用随机分配的交叉验证方法来预测个体表型,因此它们可以提供较高的预测精度; 亲属关系矩阵(kinship matrix)在工程领域被称为“kernel”。亲属关系矩阵K可以自身相乘,从而导出一个新的kernel K2=K'K。这个过程可以迭代,直到乘法没有进一步的变化。在矩阵乘法趋于均衡的过程中,乘法的最佳水平可以通过机器学习的典型训练过程来确定,eg. 通过将整个群体划分为训练和测试群体。最近,机器学习在基因组预测中的应用已经扩展到机器学习的许多领域,包括神经网络或深度学习等,这里只介绍几种用于基因组预测的机器学习方法,包括支持向量回归、随机森林、Gradient Boosting Machine和深度学习。 3.1 支持向量回归(Support Vector Regression,SVR) 支持向量机(Support Vector Machine,SVM)是在统计学习理论基础上发展起来的算法,是一种典型的非参数方法,属于监督学习方法。SVM的一个特点是它能同时最小化包含模型复杂度和训练数据误差的目标函数,可以基于结构风险最小化原则,兼顾了模型拟合和训练样本的复杂性,尤其是当我们对自己的群体数据不够了解时,SVM或许是基因组预测的备选方法。SVR通过使用kernel functions将输入空间映射到高维特征空间,利用线性模型实现非线性回归。 3.2 Random Forest (RF) and Gradient Boosting Machine (GBM) RF和GBM都是基于决策树的集成方法。RF和GBM之间的主要区别在于,RF中的决策树是独立生成的,其中个体特征(例如SNP)的更替和预测误差由可变重要性度量值表示(variable importance measurement value),它是通过平均包含特定特征的所有决策树的预测误差来计算的。GBM通过许多“weak learners”(例如,SNP的小子集)的逐步组合来构建预测模型。 3.3 Deep learning 深度学习(Deep learning)是另一类ML方法,可用于有监督和无监督学习。它通过使用多层单元(神经元)从输入数据中获得代表性信息。每个神经元计算其输入的加权和,加权和通过非线性函数传递。然后,每个层将输入数据转换为越来越抽象的表示形式。使用输入数据为该神经网络寻找最佳权重是深度学习的目标。 目前已经有研究表明,在存在显性和上位性的情况下,非参数机器学习方法BART(Bayesian additive regression trees)与随机森林、BLASSO、GBLUP和RKHS回归方法相比,给出了更小的基因组预测误差和更高的表型值预测精度。使用模拟数据集(一个性状),比较了三种机器学习方法(RF、GBM和SVM)对性状的基因组育种值(GEBVs)的预测准确性,发现GBM表现最好,其次是SVM,然后是RF。比较遗憾的是研究并没有在真实数据集中评估这些方法的效率,也没有选择用于基因组预测的SNPs子集。总的来说,在存在显性和上位性的情况下ML方法预测的效果确实优于传统线性统计模型,特别是多种ML方法组合预测效果。 GS预测准确性评估 交叉验证是在建立模型和验证模型参数时常用的办法,一般被用于评估一个模型的表现。更多的情况下,我们也用交叉验证来进行模型选择(model selection)。 一般有下面三种方法: 1)简单交叉验证 随机将样本数据集分为两部分(比如:70%的训练集,30%的测试集),然后用训练集来训练模型,在测试集上验证模型及参数。随后将样本打乱,重新选择训练集和测试集,继续训练数据和检验模型。最后选择损失函数评估最优的模型和参数。 2)K折交叉验证(K-Folder Cross Validation) 是经常用到的一种验证方法,与第一种不同,K折交叉验证先将数据集D随机划分为K个大小相同的互斥子集,每次随机选择K-1份作为训练集,剩下一份做测试集。当这一轮完成后,下一轮重新随机选择K-1份来训练数据,最后多轮结果取均值。 3)留一交叉验证(Leave-one-out Cross Validation) 是K折交叉验证的特例,即K等于样本数N。每次N-1样本训练,留一个样本验证。一般用于样本量很少的情况(如小于50)。 参考文献 [1]McGowan M, Wang J, Dong H, et al. Ideas in genomic selection with the potential to transform plant molecular breeding: A review[J]. 2020. [2]尹立林, 马云龙, 项韬, 朱猛进, 余梅, 李新云, 刘小磊, 赵书红. 全基因组选择模型研究进展及展望[J]. 畜牧兽医学报, 2019, 50(2): 233-242. [3]Moser G, Tier B, Crump R E, et al. A comparison of five methods to predict genomic breeding values of dairy bulls from genome-wide SNP markers[J]. Genetics Selection Evolution, 2009, 41(1): 1-16. [4]Li B, Zhang N, Wang Y G, et al. Genomic prediction of breeding values using a subset of SNPs identified by three machine learning methods. Front Genet 9: 1–20[J]. 2018. [5]Montesinos-López O A, Martín-Vallejo J, Crossa J, et al. New deep learning genomic-based prediction model for multiple traits with binary, ordinal, and continuous phenotypes[J]. G3: Genes, genomes, genetics, 2019, 9(5): 1545-1556.